Oracle 10g RAC asm setting #2

node2 setting

지난 포스팅 보기

Practice Date. 2013.04.16

The post about Oracle 10g RAC asm setting #2

In NODE2 setting, the screenshot from Lee Hyeung-Ki

Professor is Seo Jin-Su

Date. 2013.04.17

rac1 폴더로 이동해서

rac1.vmx, rac1.vmdk 파일을 복사합니다.

파일들은 rac2 폴더로 복사 해줍니다.

rac1.vmx를 메모장으로 열겠습니다.

File Tab을 눌릅니다.

rac2 폴더안에 있는 rac1_asm.vmx 파일을 열어줍니다.

좌측에 있는 Edit를 눌러줍니다.

rac1을 rac2로 이름 변경합니다.

이젠 rac2의 파워를 켜겠습니다.

이런 눈치챘군요, I copied it.. 눌러줍니다.

아무키나 눌러서 진행합니다.

그림과 같이 쭉~~ 진행해주시면 됩니다.

Space Bar를 눌러서 선택을 하고 Tab을 눌러서 확인합니다.

rac1과 같이 rac2에서도

Public, Private IP를 설정합니다.

/etc/hosts 파일은 rac1에서 이미 수정했음으로

건드리지 않습니다.

그림과 같이 neat에서 변경해줍니다.

DNS서버도 잊지 않고 해줍니다.

# service network restart

로그아웃 한번 합니다.

# ping rac2, rac2-priv, rac2 vip

명령들을 통해서 네트워크가 잘 작동하는지 테스트 합니다.

# vi /home/oracle/.bash_profile

커서가 있는부분에

rac1을 rac2로 변경해줍니다.

node2 setting이 끝이났습니다.

![]()

이어서 Clusterware Install 하겠습니다.

자자~!! 졸리시면 기지개 한번 펴시고!!

winscp를 이용해서 node1에

p8202632_10205_LINUX.zip, 10201_clusterware_linux32.zip(Clusterware),

10201_database_linux32.zip(Engeen), p4198954_40_LINUX.zip(patch)를

/home/oracle 로 복사해줍니다.

압축을 풀어줍니다.

# unzip p4198954_40_LINUX.zip.......

# chown -R oracle.dba /home/oracle/

소유권을 변경해 줍니다.

# chown -R oracle.dba /home/oracle/

rac2에도 역시 소유권을 변경해 줍니다.

node1을 oracle 계정으로 바꿉니다.

# mkdir .ssh

권한을 700으로 줍니다.

# ssh-keygen -t rsa

# ssh-keygen -t dsa

로 ssh key를 만들어 줍니다.

입력하라는건 모두 enter key를 쳐줍니다.

node2 역시 마찬가지로 작업합니다.

node1에서

$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

$ cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

입력 후

$ ssh rac2 cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

를 입력한뒤 yes, 이후 node2의 패스워드를 입력하시면 됩니다.

node2의 패스워드만 넣어주면 끝!

node1, node2 에서

$ ssh rac1 date

$ ssh rac1-priv date

$ ssh rac2 date

$ ssh rac2-priv date

처음 입력하면 password를 물어봅니다. 그 뒤 다시 명령어를 쳤을때는 password를 묻지않고

바로 날짜가 나온다면 성공하신겁니다. ^^

node1, node2에서 모두 확인하셔야 하며, root 계정으로 ssh를 진행 하셨다면 에러가 날것 입니다.

node1에서 p4198954_40_LINUX.zip을 풀어줍니다. 그러면 생성되는 rpm2개를 설치해줍니다.

이 rpm은 oracle10g 설치오류에 대한 patch 입니다.

rpm –Uvh명령으로 설치합니다. 이 rpm들을 설치하기 전에 RHEL4 3번CD안에 있는

/media/cdrom/RedHat/RPMS 폴더에서 libaio-devel 패키지를 먼저 설치 합니다.

# cd clusterware/rpm 폴더로 이동후

# export CVUQDISK_GRP=dba 로 환경설정을 하고

# rpm –Uvh cvuqdisk-1.0.1-1.rpm 으로 설치를 해줍니다.

# scp cvuqdisk-1.0.1-1.rpm rac2:~/

명령으로 rac2에 rpm을 옮겨줍니다.

rac2로 이동해서 rac1과 동일한 환경을 설정해 줍니다.

# export CVUQDISK_GRP=dba

# rpm –Uvh cvuqdisk-1.0.1-1.rpm

equivalence 검사를 합니다.

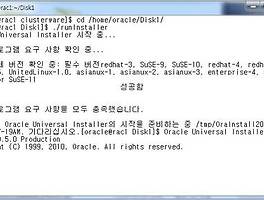

# cd /home/oracle/clusterware/cluvfy

# ./runcluvfy.sh stage -pre crsinst -n rac1,rac2 -verbose

equivalence 검사창에서 성공이 나온다면 성공입니다.

검사를 이어서..

# ./runcluvfy.sh stage -post hwos -n rac1,rac2 -verbose

equivalence 검사창에서 성공이 나온다면 성공입니다.

rac1에 oracle계정으로 로그인 하신 뒤

$ cd /home/oracle/clusterware/

$ ./runInstaller

다음을 눌러줍니다.

그냥 다음~

여기서 경로에는 bash파일에 설정한대로 설정을 해주어야 합니다.

위에서 우리는 clusterware의 경로를

/home/oracle/product/10.2/crs로 했으니 똑같이 넣어줍니다.

한국어 겠죠?

다 성공하셨으면 다음을 눌러줍니다.

클러스터를 구성하기 위해서 여기서 추가를 눌러줍니다.

/etc/hosts에 설정한대로 입력해주시면 됩니다.

공용 노드 이름 : rac2

전용 노드 이름 : rac2-priv

가상 호스트 이름 : rac2-vip

로 입력을 해줍니다.

정상적으로 입력이 되었으면 다음을 눌러줍니다.

eth0을 선택하신후 편집을 눌러줍니다.

전용이던 기본값을 공용으로 변경합니다.

그리고 확인! 그리고 다음!

OCR의 위치는 그림과 같이 입력해 줍니다.

/dev/raw/raw1

/dev/raw/raw2

계속 입력해 줍니다.

/dev/raw/raw3

/dev/raw/raw4

/dev/raw/raw5

설치를 눌러서 다음으로 넘어갑니다.

설치가 거의 다 진행이 되고나면 위와같이 root권한으로 스크립트를 실행해달라는

창이 하나 뜹니다.

rac1에서

# /hoem/oracle/oraInventory/orainstRoot.sh

를 실행해 줍니다.

마찬가지로 rac2에서도

# /hoem/oracle/oraInventory/orainstRoot.sh

를 실행해 줍니다.

다시 rac1으로 와서

# /home/oracle/product/10.2/crs/root.sh

를 실행 합니다. 시간이 좀 걸리는 편입니다. 기다려주세요!

다시 rac2으로 와서

# /home/oracle/product/10.2/crs/root.sh

를 실행 합니다. 시간이 좀 걸리는 편입니다. 기다려주세요! ^^

다 진행이 되고나면 설치창으로 가기전에 한가지 더 할일이 있습니다.

rac2에서

# vipca

를 입력합니다.

rac2창에 vipca 설치화면이 떠있습니다.

eth0을 선택후 다음을 눌러줍니다.

IP별칭 이름란에 rac1-vip, rac2-vip라고 입력해 줍니다.

나머지칸은 자동으로 채워집니다.

입력한 정보를 확인하고나서 완료버튼을 눌러줍니다.

잘 진행이 되고 있습니다.

이런 오류가 나타난다면 당황하지 마시고 rac2 root계정으로 putty에 접속합니다.

# /etc/hosts

를 열어서 보면 rac1, rac2 정보만 있고

127.0.0.1 localhost 부분이 빠져있습니다.

이게 없어서 에러가 발생했으므로 입력을 하고 저장한뒤 vipca에서

재시도를 눌러줍니다.

네! 성공했습니다! 확인을 눌러주세요!

확인을 눌러줍니다.

Clusterware의 설치가 끝났습니다.

종료!!! 확인!!!!

수고하셨습니다. RAC asm setting #2가 끝났습니다.

아직 많이 남았으니 #3, #4 까지 갈것 같습니다.

감사합니다.

By. sTricky

'Database > ORACLE' 카테고리의 다른 글

| Oracle 10g RAC asm setting #3 (0) | 2013.04.25 |

|---|---|

| SQL class #1 DESC (0) | 2013.04.24 |

| Oracle 10g RAC asm setting #1 (0) | 2013.04.10 |

| Oracle 11g Silent setting in OEL5 설치 안내 (0) | 2013.04.09 |

| OEL 5 + Oracle 11g for Linux 설치법 (0) | 2013.04.08 |